Hace unas semanas la actriz Milett Figueroa denunció que su madre, Martha Valcárcel, recibió una llamada de unos estafadores que intentaron quitarle dinero usando una una voz extremadamente parecida a la de su hermana, diciéndole que estaba secuestrada. ¿Qué ocurrió? Los delincuentes han empezado a clonar voces de personas reales con la ayuda de la inteligencia artificial (IA).

“¡Acaban de llamar a la casa unos estafadores y mamá contestó el teléfono, le dijeron que habían secuestrado a mi hermana y casi le da un infarto! La persona tenía la voz de mi hermana o parecida ella, ¿cómo es posible que exista gente tan así? Felizmente, todos estamos bien”, escribió la conocida modelo.

Días después de esta denuncia de Milett, la campaña ‘pasa en la calle’ del diario ‘El Comercio recogió otros 55 casos similares en los que las víctimas oyeron, al otro lado del teléfono, una voz exacta a la de un familiar solicitando dinero por alguna “urgencia” o amenaza.

“Llamaron a mi casa para decirnos que mi hermano estaba secuestrado y pedían muchísimo dinero. Pero él estaba en su habitación descansando”, reveló Manuel Flores Días, una de las pocas víctimas que quisieron identificarse.

Otra usuaria comentó que llamaron a su casa y le dijeron lo mismo que a la madre de Milett. “Aseguraron que mi hermano estaba secuestrado y lo pusieron al teléfono. La voz era muy parecida, estaba pidiendo ayuda. Fue desesperante y me moría de miedo”, contó.

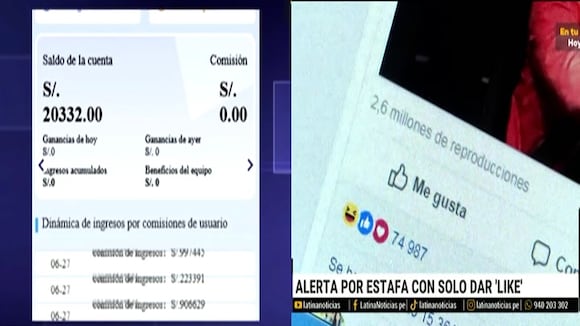

¿CÓMO OPERAN ESTOS DELINCUENTES?

Erick Iriarte, abogado experto en derecho digital y nuevas tecnologías, explicó a este Diario que se trata de la técnica del ‘deepfake’: programas que permiten escribir un texto para que sea convertido de forma casi inmediata en la misma voz de los audios que se obtuvieron previamente en las redes sociales de la víctima. En Estados Unidos, en enero de este año, comenzó a reportarse casos donde incluso algunas víctimas llegaron a pagar.

El Ministerio Público también confirmó a El Comercio la existencia de casos similares, aunque indicaron que, por la complejidad técnica que demanda su investigación, los fiscales los vienen revisando de manera individual.

“Al ser delitos de estafas que utilizan tecnologías de la información, las denuncias son atendidas por las fiscalías penales de turno, pudiendo recurrir a la Unidad Fiscal Especializada en Ciberdelincuencia para solicitar un acompañamiento técnico y así acceder al tratamiento de la evidencia digital”, indicaron en un comunicado.

¿CÓMO CONSIGUEN LAS VOCES?

Rodrigo Ochoa, líder de automatización e inteligencia artificial en Moventi, señaló que la IA está programada para poder reproducir un audio con las palabras que los estafadores escribieron previamente en el sistema. Es así que supuestamente le pasan el teléfono a la falsa víctima para decir frases como “ayúdame por favor”. “Se deben tener varios audios grabados para que la IA pueda registrarlos y luego el programa pueda hacer la representación”, dijo.

Estos programas también pueden encontrarse abiertamente en Internet. “Mientras más audios se tengan de la persona para que la IA pueda estudiarlos, la voz clonada se escuchará más real”, comentó.

Gustavo Vallejo, especialista en ciberseguridad, señaló que “esto le puede pasar a cualquier ciudadano que tenga una presencia activa en redes sociales y genere videos”. Esa es la forma en la que los estafadores obtendrán el material.

Cuando los delincuentes clonan el audio de una persona, en paralelo van obteniendo información básica sobre familiares. “Se utiliza el método de ingeniería social: los ciberdelincuentes atan cabos hasta acceder finalmente a la lista de contactos de sus víctimas”, agregó.

VIDEO RELACIONADO